Welcome to WikiLivres

Books can transport you. A great man once said that reading books is like living many lives. We believe that reading has the power to let people experience multiple facets of life that cannot be experienced within a single lifetime. Gaining knowledge and insight into the lives and experiences of others through the books we read widens the horizon of our perspective. It breeds awareness, understanding, and tolerance to people’s differences.

-

8 Literature Review Games for Students

By Vicki Johnson 2 months agoDiving into literature doesn't have to be a snooze fest! With the right classroom review games, you can turn those...

-

How Vaping Helps Improve Your Reading Experience

By Vicki Johnson 4 months agoAs you settle into your favorite reading nook with a book in one hand, you might want to consider the...

-

Top Books on Blockchain and Cryptocurrency for Bitcoin Casino Enthusiasts

By Vicki Johnson 6 months agoIn the fast-evolving world of blockchain and cryptocurrency, staying informed is crucial for enthusiasts, especially those engaged in the exciting...

-

5 Books about Vaping That Are Worth Reading

By Vicki Johnson 1 year agoAfter spending a long day, it’s great to unwind with a good book and a trusty vape pen. If you...

-

Top 5 Best GRE Prep Books in 2024

By Vicki Johnson 2 years agoPassing a GRE test is the last step towards getting into a world-class graduate program. A big part of the...

-

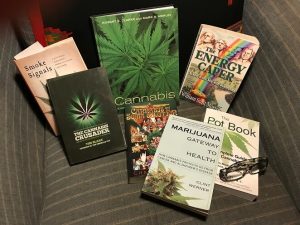

4 Best Cannabidiol Books for In-Depth Knowledge

By Vicki Johnson 3 years agoThe issue with CBD oil Canada is that there's too much to know, but concrete information is difficult to come...

-

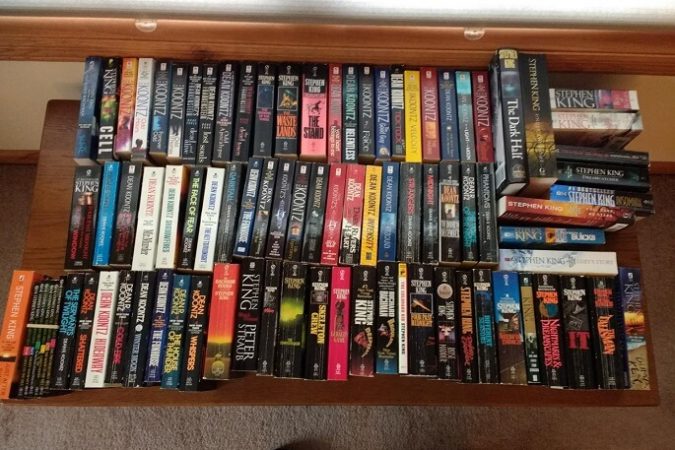

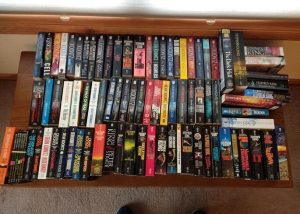

The 16 Best Dean Koontz Books for the Chills

By Vicki Johnson 3 years agoDemon Seed (1973) Technology's advancement, without human-like ambition motivating it, is terrifying enough. And this is not limited to things...

-

What March Has to Offer

By Vicki Johnson 4 years agoCountless must-reads are hitting the shelves every month. There’s a lot more than we can name here. But, no matter...

-

The Best Mysteries and Thrillers of March

By Vicki Johnson 4 years agoMarch brought mystery and thriller novel fans that will keep them reading for hours on end: Eight Perfect Murders by...

-

Weekend Reading

By Vicki Johnson 5 years agoFor months, we won’t be having any choice but to stay inside. For months, every day is going to feel...

-

The Best Children’s Books of 2019

By Vicki Johnson 4 years agoWe’ve written down 2019’s top reads that made the year a blast for children. Parents are grateful for these books...

-

Mysteries Set in the World of Books

By Vicki Johnson 4 years agoReaders must be missing bookstores now more than ever, but we have no choice but to stay behind closed doors...

-

8 Literature Review Games for Students

By Vicki Johnson 2 months agoDiving into literature doesn't have to be a snooze fest! With the right classroom review games, you can turn those...

-

How Vaping Helps Improve Your Reading Experience

By Vicki Johnson 4 months agoAs you settle into your favorite reading nook with a book in one hand, you might want to consider the...

-

Top Books on Blockchain and Cryptocurrency for Bitcoin Casino Enthusiasts

By Vicki Johnson 6 months agoIn the fast-evolving world of blockchain and cryptocurrency, staying informed is crucial for enthusiasts, especially those engaged in the exciting...

-

5 Books about Vaping That Are Worth Reading

By Vicki Johnson 1 year agoAfter spending a long day, it’s great to unwind with a good book and a trusty vape pen. If you...

-

Top 5 Best GRE Prep Books in 2024

By Vicki Johnson 2 years agoPassing a GRE test is the last step towards getting into a world-class graduate program. A big part of the...

-

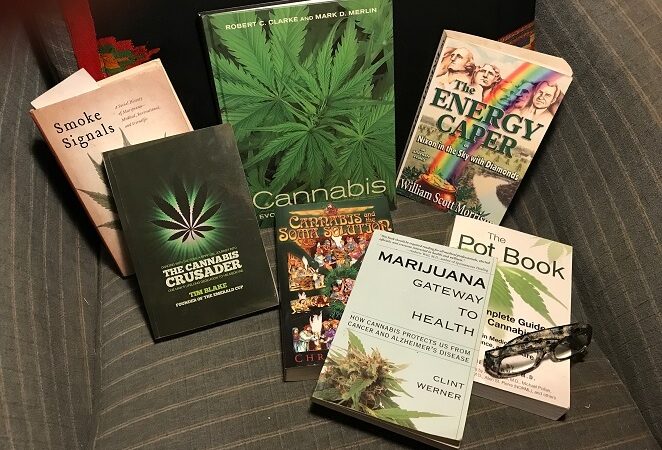

4 Best Cannabidiol Books for In-Depth Knowledge

By Vicki Johnson 3 years agoThe issue with CBD oil Canada is that there's too much to know, but concrete information is difficult to come...

-

The 16 Best Dean Koontz Books for the Chills

By Vicki Johnson 3 years agoDemon Seed (1973) Technology's advancement, without human-like ambition motivating it, is terrifying enough. And this is not limited to things...

-

What March Has to Offer

By Vicki Johnson 4 years agoCountless must-reads are hitting the shelves every month. There’s a lot more than we can name here. But, no matter...

-

7 Fireplace Bookshelves Ideas

By Vicki Johnson 2 months agoPeople enjoy reading near a fireplace because it offers a cozy atmosphere. Fireplaces create an ideal setting for immersive reading....

-

Best Sci-Fi and Fantasy Reads of 2019

By Vicki Johnson 4 years agoOne of the good things that comes with a new year is making a list of the best reads of...

-

Spring Surprises: Sci-Fi and Fantasy Novels to Hit the Shelves in the First Quarter of 2020

By Vicki Johnson 4 years agoAnother decade has passed, and 2020 beams on the horizon with its promise to give us surprises in the sci-fi...

-

Epic Reads: The Best Sci-Fi and Fantasy Saga for 2020

By Vicki Johnson 4 years agoThe best dilemma in the universe is probably deciding which sci-fi and fantasy series to start reading next. Let us...

Featured

8 Literature Review Games for Students

How Vaping Helps Improve Your Reading Experience

Top Books on Blockchain and Cryptocurrency for Bitcoin Casino Enthusiasts

5 Books about Vaping That Are Worth Reading

Top 5 Best GRE Prep Books in 2024

4 Best Cannabidiol Books for In-Depth Knowledge

The 16 Best Dean Koontz Books for the Chills